當(dāng)前位置:首頁 > 學(xué)習(xí)資源 > 講師博文 > 強化學(xué)習(xí)(RL)在機器人抓取任務(wù)中的稀疏獎勵與課程學(xué)習(xí)策略

強化學(xué)習(xí)(RL)在機器人抓取任務(wù)中的稀疏獎勵與課程學(xué)習(xí)策略

時間:2025-05-28 來源:華清遠見

強化學(xué)習(xí)(RL)在機器人抓取任務(wù)中的稀疏獎勵與課程學(xué)習(xí)策略

時間:2025-05-28 來源:華清遠見

稀疏獎勵

通常在訓(xùn)練智能體時,我們希望每一步動作都有相應(yīng)的獎勵。但是某些情況下,智能體并不能立刻獲得獎勵,比如全局獎勵的圍棋,最終獲勝會得到獎勵,但是人們很難去設(shè)定中間每步的獎勵,這會導(dǎo)致學(xué)習(xí)緩慢甚至無法進行學(xué)習(xí)的問題。

2.解決方法

2.1 設(shè)計獎勵(reward shaping)

除了最終要學(xué)習(xí)到的目標(biāo)外,可以額外添加一些獎勵用于引導(dǎo)智能體。比如ViZDoom射擊游戲,殺了敵人得到正獎勵,被殺得到負獎勵。探究人員設(shè)計了一些新獎勵,來引導(dǎo)智能體做的更好,比如掉血就扣分,撿到補給包會加分,待在原地扣分,活著扣一個很小的分(否則智能體只想活著,躲避敵人)等方法。reward shaping技術(shù)需要領(lǐng)域知識(domain knowledge),不合理的設(shè)計獎勵方式會讓智能體學(xué)習(xí)到錯誤的方法。比如希望機器人將藍色板子穿過柱子,通常會想到板子靠近柱子就加分,距離越近獎勵越大,但是這樣機器人可能會學(xué)習(xí)到用藍色板子打柱子,而不是從上面穿過。因此設(shè)計獎勵的效果與領(lǐng)域知識有關(guān),需要調(diào)整。

2.2 好奇心(curiosity)

自己加入并且一般看起來有用的獎勵,比如給智能體加上好奇心,稱為好奇心驅(qū)動的獎勵(curiosity driven reward),在好奇心驅(qū)動的技術(shù)里,我們會加入一個新的獎勵函數(shù):內(nèi)在好奇心模型(intrinsic curiosity module,ICM)。ICM模塊需要3個輸入:狀態(tài)s1,動作a1,狀態(tài)s2,根據(jù)輸入輸出另外一個獎勵rc(1)。對于智能體,在與環(huán)境交互時,不僅希望原始獎勵r越大,也希望好奇心獎勵rc越大。如何設(shè)計好奇心模塊?用一個網(wǎng)絡(luò),接受輸入a(t),s(t),輸出,也就是用這個網(wǎng)絡(luò)去預(yù)測,看預(yù)測值與真實s(t+1)的相似度,越不相似獎勵越高。也就是說,好奇心獎勵的意義在于:未來的狀態(tài)越難被預(yù)測,得到的獎勵就越大,這樣方便探索未知的世界。

好奇心模塊的設(shè)置有一個問題:某些狀態(tài)很難被預(yù)測到并不代表它就是好的,就是需要被嘗試的。比如某些游戲中,會突然出現(xiàn)樹葉飄動,這是無法預(yù)測的,智能體會一直看著樹葉飄動。因此智能體僅有好奇心是不夠的,還需要知道什么事情是真正重要的。

為了知道什么事情是重要的,避免不必要的冒險,要加上另外一個模塊,學(xué)習(xí)特征提取器(feature extractor) 。如圖所示,黃色格子是特征提取器,輸入一個狀態(tài)s(t),輸出一個特征向量表示這個狀態(tài),特征提取器可以把無意義的東西過濾掉。那么內(nèi)在好奇心網(wǎng)絡(luò)1實際上輸入的是a(t)和特征向量,輸出下一狀態(tài)特征向量。如何學(xué)習(xí)特征提取器,通過網(wǎng)絡(luò)2學(xué)習(xí),網(wǎng)絡(luò)2輸入和,輸出預(yù)測動作,這個動作與真實動作越接近越好。網(wǎng)絡(luò)2是用提取后的特征向量預(yù)測動作,因此像風(fēng)吹草動這種與智能體動作無關(guān)的信息就會被過濾掉。

機器人抓取任務(wù)因環(huán)境動態(tài)性、物體多樣性及動作連續(xù)性,成為強化學(xué)習(xí)(RL)的典型挑戰(zhàn)場景。其中,**稀疏獎勵(Sparse Reward)和課程學(xué)習(xí)(Curriculum Learning)**是優(yōu)化訓(xùn)練效率與成功率的關(guān)鍵技術(shù)。以下從問題分析、策略設(shè)計到實驗優(yōu)化進行系統(tǒng)性闡述。

1. 稀疏獎勵的核心挑戰(zhàn)

1.1 稀疏獎勵的成因

任務(wù)特性:僅在抓取成功時給予正獎勵(+1),其余時刻無反饋(0)。

探索難度:機械臂需精確控制位姿、力度,隨機探索難以觸發(fā)成功事件。

局部最優(yōu)陷阱:過早收斂到次優(yōu)策略(如反復(fù)觸碰物體但無法抓取)。

1.2 稀疏獎勵的負面影響

樣本效率低下:需數(shù)百萬次交互才能偶然獲得成功經(jīng)驗。

訓(xùn)練不穩(wěn)定:梯度估計方差大,策略網(wǎng)絡(luò)難以收斂。

仿真-現(xiàn)實鴻溝:仿真中過度依賴密集獎勵,遷移到真實機器人時失效。

2. 稀疏獎勵解決方案

2.1 內(nèi)在獎勵(Intrinsic Reward)

好奇心驅(qū)動探索:

ICM(Intrinsic Curiosity Module):通過預(yù)測環(huán)境動態(tài)的誤差生成獎勵,鼓勵探索未知狀態(tài)。

RND(Random Network Distillation):利用隨機網(wǎng)絡(luò)差異衡量狀態(tài)新穎性。

機器人應(yīng)用示例:機械臂嘗試不同抓取角度時,因位姿新穎性獲得內(nèi)在獎勵,加速發(fā)現(xiàn)可行策略。

2.2 目標(biāo)導(dǎo)向經(jīng)驗回放(Goal-Based HER)

Hindsight Experience Replay(HER):

核心思想:將未達成目標(biāo)的軌跡視為新目標(biāo)(“雖然沒抓到A,但抓到了B”)。

實現(xiàn)步驟:

# HER偽代碼示例for episode in trajectories:

achieved_goals = episode['achieved_goals']

for t in range(len(episode)):

new_goal = achieved_goals[-1] # 使用最終達到的目標(biāo)作為新目標(biāo)

reward = compute_reward(episode['actions'][t], new_goal)

replay_buffer.store(episode[t], new_goal, reward)

效果:在Fetch機器人抓取任務(wù)中,成功率從12%提升至80%以上。

2.3 分層強化學(xué)習(xí)(HRL)

Option-Critic架構(gòu):

高層策略:選擇子目標(biāo)(如“靠近物體”“調(diào)整夾爪姿態(tài)”)。

底層策略:執(zhí)行具體動作(關(guān)節(jié)角度控制)。

優(yōu)勢:通過子目標(biāo)分解稀疏獎勵,降低探索難度。

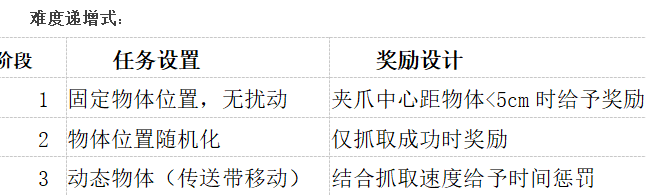

3. 課程學(xué)習(xí)策略設(shè)計

3.1 課程生成方法

自動課程生成(Automatic Curriculum Learning):

ALP-GMM:基于策略性能動態(tài)調(diào)整任務(wù)分布,優(yōu)先訓(xùn)練“中等難度”樣本。

PAIRED:通過對抗環(huán)境生成器創(chuàng)建漸進式挑戰(zhàn)任務(wù)。

3.2 課程學(xué)習(xí)與遷移

域隨機化(Domain Randomization):

參數(shù)范圍:物體質(zhì)量、摩擦力、視覺紋理、光照條件隨機化。

作用:增強策略魯棒性,縮小Sim2Real差距。

示例:NVIDIA Isaac Gym中訓(xùn)練機械臂策略,遷移到真實UR5機械臂時成功率保持85%以上。

漸進式模型遷移:

在理想仿真環(huán)境(無噪聲)中訓(xùn)練基礎(chǔ)策略。

逐步添加傳感器噪聲、延遲等擾動微調(diào)策略。

最后在真實機器人上進行少量樣本微調(diào)(Few-Shot Adaptation)。

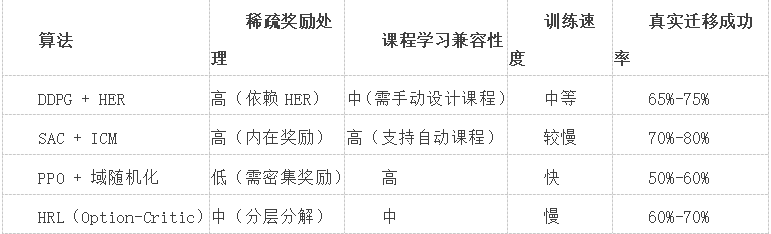

4. 算法實現(xiàn)與實驗優(yōu)化

4.1 典型算法對比

4.2 關(guān)鍵超參數(shù)優(yōu)化

獎勵縮放(Reward Scaling):內(nèi)在獎勵與外部獎勵的權(quán)重平衡(如λ=0.1)。

課程切換閾值:當(dāng)連續(xù)10個episode成功率超過90%時進入下一階段。

探索噪聲衰減:ε-greedy策略的噪聲標(biāo)準(zhǔn)差隨訓(xùn)練線性遞減。

4.3 計算加速技術(shù)

并行仿真:使用NVIDIA Isaac Sim同時運行1000個環(huán)境實例。

混合精度訓(xùn)練:FP16神經(jīng)網(wǎng)絡(luò)計算,吞吐量提升2倍。

邊緣-云協(xié)同訓(xùn)練:在本地機器人執(zhí)行推理,云端集群異步更新模型。

5. 典型應(yīng)用案例

5.1 工業(yè)分揀機器人(ABB YuMi)

策略架構(gòu):SAC + HER + 自動課程學(xué)習(xí)。

性能:在雜亂物體堆中抓取成功率92%,訓(xùn)練時間從120小時縮短至40小時。

5.2 服務(wù)機器人抓取(Boston Dynamics Spot)

挑戰(zhàn):動態(tài)環(huán)境(行走中抓取)、多模態(tài)感知(RGB-D+力覺)。

方案:分層RL(高層路徑規(guī)劃+底層抓取控制)+ 域隨機化。

結(jié)果:在未知物體抓取任務(wù)中達到78%成功率。

6. 未來研究方向

語言引導(dǎo)課程學(xué)習(xí):利用LLM(如GPT-4)自動生成任務(wù)描述與課程規(guī)劃。

多機器人協(xié)作課程:通過競爭或合作機制分配不同難度任務(wù)。

元課程學(xué)習(xí)(Meta-Curriculum):學(xué)習(xí)如何生成課程,適應(yīng)未知任務(wù)分布。

總結(jié)

針對機器人抓取的稀疏獎勵問題,內(nèi)在獎勵引導(dǎo)探索與HER增強經(jīng)驗復(fù)用是提升樣本效率的核心;結(jié)合漸進式課程學(xué)習(xí)與域隨機化,可顯著提高策略魯棒性與跨域遷移能力。實際部署中需權(quán)衡訓(xùn)練速度與穩(wěn)定性,選擇DDPG+HER或SAC+ICM等組合,并通過并行化加速迭代。未來,隨著自動課程生成與多模態(tài)感知的融合,RL在復(fù)雜抓取任務(wù)中將進一步逼近人類水平。

基于因果推理的時序數(shù)據(jù)異常檢測與根因定位模型設(shè)計

基于因果推理的時序數(shù)據(jù)異常檢測與根因定位模型設(shè)計 強化學(xué)習(xí)(RL)在機器人抓取任務(wù)中的稀疏獎勵與課程學(xué)

強化學(xué)習(xí)(RL)在機器人抓取任務(wù)中的稀疏獎勵與課程學(xué) 嵌入式多核處理器中的任務(wù)遷移與負載均衡算法設(shè)計與性

嵌入式多核處理器中的任務(wù)遷移與負載均衡算法設(shè)計與性 基于事件驅(qū)動的嵌入式系統(tǒng)低功耗設(shè)計:從傳感器采樣到

基于事件驅(qū)動的嵌入式系統(tǒng)低功耗設(shè)計:從傳感器采樣到 基于 Zephyr RTOS 的嵌入式藍牙 Mesh 網(wǎng)絡(luò)節(jié)點設(shè)計與

基于 Zephyr RTOS 的嵌入式藍牙 Mesh 網(wǎng)絡(luò)節(jié)點設(shè)計與 超大規(guī)模模型訓(xùn)練中的 ZeRO 優(yōu)化器與混合精度通信壓縮

超大規(guī)模模型訓(xùn)練中的 ZeRO 優(yōu)化器與混合精度通信壓縮 聯(lián)邦學(xué)習(xí)(FL)中的梯度噪聲注入與差分隱私保護平衡策略

聯(lián)邦學(xué)習(xí)(FL)中的梯度噪聲注入與差分隱私保護平衡策略 基于TinyML的嵌入式設(shè)備端語音喚醒詞檢測模型輕量化部

基于TinyML的嵌入式設(shè)備端語音喚醒詞檢測模型輕量化部 嵌入式無線通信中的自適應(yīng)跳頻抗干擾算法與頻譜效率分

嵌入式無線通信中的自適應(yīng)跳頻抗干擾算法與頻譜效率分 嵌入式系統(tǒng)硬件安全:物理不可克隆功能(PUF)密鑰生

嵌入式系統(tǒng)硬件安全:物理不可克隆功能(PUF)密鑰生