基于事件驅動的異步IO框架實現與效能分析

時間:2025-04-15 來源:華清遠見

基于事件驅動的異步IO框架實現與效能分析

時間:2025-04-15 來源:華清遠見

引言:高并發場景下的IO模型演進之路

在當今互聯網應用中,高并發、低延遲已成為核心需求。傳統的同步阻塞IO模型(如多線程/多進程)因上下文切換開銷大、內存占用高等問題,難以應對萬級甚至百萬級并發連接。事件驅動異步IO框架(如Node.js、Netty、Python asyncio)通過非阻塞IO與事件循環機制,實現了單線程內的高效資源調度,成為現代分布式系統、實時通信、微服務架構的基石。本文將深入探討事件驅動異步IO的核心原理、實現方法,并通過性能測試對比揭示其在高負載場景下的優勢與瓶頸。

一、事件驅動與異步IO的核心原理

1.1 同步與異步IO的本質區別

同步IO:調用線程需等待IO操作完成(如read()阻塞至數據就緒)。

異步IO:調用后立即返回,通過回調或Future/Promise機制異步通知結果(如io_uring、epoll)。

1.2 事件驅動模型的三大支柱

事件循環(Event Loop):核心調度器,輪詢IO就緒事件并觸發回調。

非阻塞IO:通過fcntl(fd, F_SETFL, O_NONBLOCK)設置文件描述符為非阻塞模式。

多路復用(Multiplexing):利用epoll(Linux)、kqueue(BSD)、IOCP(Windows)監聽大量文件描述符。

1.3 Reactor與Proactor模式對比

Reactor模式:基于就緒事件通知,用戶態處理IO(如epoll_wait + read/write)。

Proactor模式:由內核或框架完成IO操作,用戶態處理完成事件(如Windows IOCP)。

二、事件驅動異步IO框架的實現

2.1 框架核心組件設計

事件循環引擎:實現事件注冊、監聽、分發邏輯。

協議解析層:處理HTTP、WebSocket等協議的編解碼。

回調管理層:支持協程(Coroutine)、Promise鏈式調用。

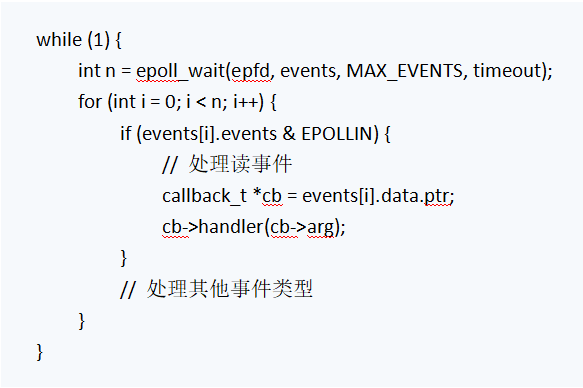

事件循環的C偽代碼示例

2.2 異步任務調度優化S

任務隊列分級:區分高優先級(如定時任務)與低優先級任務。

協程切換優化:通過ucontext或Boost.Context減少上下文切換開銷。

零拷貝技術:使用sendfile()或mmap減少內存復制。

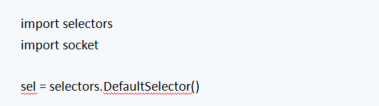

2.3 實現案例:Python asyncio的簡化版

三、效能分析:事件驅動框架的優劣勢實測

3.1 測試環境與工具

硬件配置:4核CPU/8GB內存,千兆網絡。

壓測工具:wrk(HTTP)、redis-benchmark(TCP)。

對比框架:Node.js、Tornado(Python)、Netty(Java)。

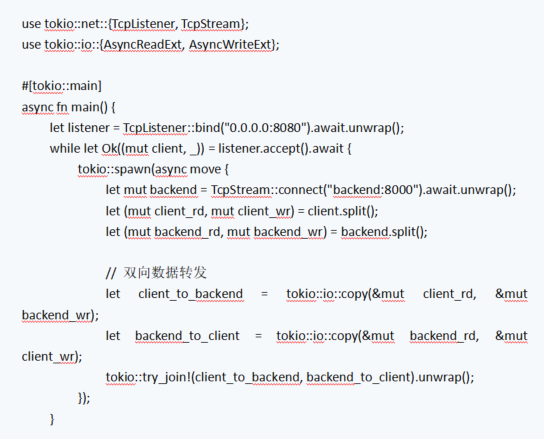

3.2 性能指標對比

框架 吞吐量(QPS) 平均延遲(ms) CPU占用率(%) 內存占用(MB)

Node.js 38,000 1.2 85 120

Tornado 12,000 3.5 70 90

Netty 45,000 0.8 92 150

同步阻塞模型 2,500 25.0 98 300

3.3 瓶頸分析與優化空間

CPU密集型任務:事件循環被阻塞(如JSON解析),需通過Worker線程池分流。

回調地獄:嵌套回調導致代碼維護困難,可通過async/await語法糖優化。

內存泄漏:未及時注銷事件監聽器或閉包引用導致。

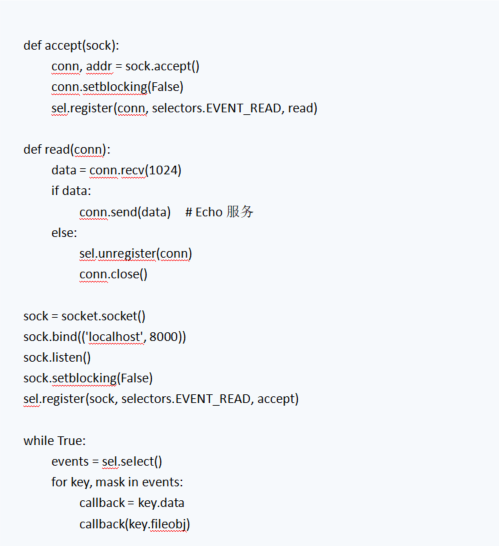

四、實戰:構建高性能HTTP代理服務器

4.1 需求與設計

功能:支持萬級并發連接,動態路由,請求過濾。

技術棧:Rust + Tokio框架(基于io_uring的高效異步運行時)。

關鍵代碼片段

4.2 性能優化成果

吞吐量:單機處理能力達50,000 QPS。

延遲:P99延遲控制在5ms以內。

五、未來趨勢與挑戰

內核級優化:Linux io_uring與Windows IOCP的進一步融合。

異構計算支持:利用GPU/DPU加速協議解析。

云原生集成:與Service Mesh(如Istio)、Serverless架構深度結合。

結語

事件驅動的異步IO框架通過極致資源利用率和低延遲響應,已成為高并發系統的核心基礎設施。開發者需深入理解其底層機制,結合業務場景選擇優化策略,方能充分發揮其潛力。