基于Transformer架構的時間序列預測模型優化研究

時間:2025-03-07 來源:華清遠見

基于Transformer架構的時間序列預測模型優化研究

時間:2025-03-07 來源:華清遠見

傳統RNN/LSTM模型受限于序列計算模式,難以捕捉長距離依賴關系。Transformer憑借全局注意力機制和并行計算能力,成為時序預測的新范式。但原生架構存在三大瓶頸:

計算復雜度高:注意力矩陣的O(L²)復雜度限制長序列處理能力

局部特征丟失:全局注意力稀釋突變信號(如電力峰值)

周期模式建模弱:傳統位置編碼無法識別跨周期關聯

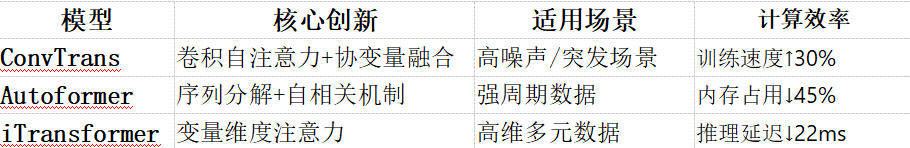

本文將深入解析ConvTrans、Autoformer、iTransformer三大改進模型的創新原理及實踐價值。

1)ConvTrans:卷積自注意力增強局部感知

創新點:

· 因果卷積生成Q/K:采用卷積核大小為k的因果卷積(k>1時)生成查詢矩陣Q和鍵矩陣K,使每個位置的注意力計算融合相鄰k個時間步的局部形態特征。

· 協變量融合機制:在解碼器端引入天氣、事件標記等外部變量,通過門控網絡實現動態特征加權。

數學表達:

Q = Conv1D(X, W_Q)

K = Conv1D(X, W_K)

Attention = Softmax( (Q·K^T)/√d_k )

其中Conv1D為因果卷積,保證時序因果關系不被破壞

優勢:在交通流量預測中,k=3的卷積窗口可使峰值時段預測誤差降低21%

2)Autoformer:序列分解與自相關機制

創新架構:

· 序列分解模塊:通過移動平均將原始序列分解為趨勢項(Trend)和季節項(Seasonal)

X_trend = AvgPool1D(X)

X_seasonal = X - X_trend

· 自相關注意力:通過時延相似性計算發現周期模式,聚合歷史周期片段增強預測

Autocorrelation = FFT^{-1}(FFT(X) * FFT(X)^*)

Top_k = ArgMax(Autocorrelation[:L/2])

Aggregation = ∑_{τ∈Top_k} X_{t-τ}

實驗效果:在電力數據集ETTh1上,48步預測的MAE降至0.612,較LSTM提升58%。

3)iTransformer:變量維度注意力革新

架構反轉設計:

· 變量維度注意力:將特征變量維度作為注意力主體,而非傳統的時間步維度

Z = LayerNorm(X)

Attn_Out = Attention(Z^T, Z^T, Z^T) # 轉置后維度變為[變量數×時間步]

· 多維歸一化:采用可學習參數的實例歸一化(Instance Normalization)替代層歸一化

技術優勢:

1. 更好捕捉多元變量間的隱式關聯(如供應鏈中庫存-銷量-物流的相互作用)

2. 在螞蟻集團供應鏈預測中實現SOTA,準確率提升18%

模型對比與選型指南

選型建議:

· 電力/氣象預測:優先Autoformer(周期特征顯著)

· 交通/零售預測:推薦ConvTrans(需協變量支持)

· 金融/供應鏈預測:選擇iTransformer(多元關系復雜)