批歸一化(Batch Normalization)在深度學習中的作用

時間:2025-01-09 來源:華清遠見

批歸一化(Batch Normalization)在深度學習中的作用

時間:2025-01-09 來源:華清遠見

在深度學習的研究和應用中,神經網絡模型的訓練過程常常充滿挑戰。隨著網絡層數的加深,訓練深度神經網絡時經常出現梯度消失或梯度爆炸的問題,導致訓練速度緩慢,甚至無法收斂。為了解決這一問題,批歸一化(Batch Normalization, BN)應運而生,它不僅能夠加速網絡的訓練過程,還能提高模型的穩定性和泛化能力。

本文將詳細探討批歸一化的工作原理、在深度學習中的作用,以及它在實際應用中的優勢與挑戰。

一、批歸一化的工作原理

批歸一化(BN)最初由Sergey Ioffe和Christian Szegedy在2015年提出,它的核心思想是在每一層的輸入數據上進行標準化,使得每層的輸入具有相同的分布特征。這一操作可以有效地緩解神經網絡訓練中的一些常見問題。

1.1 BN的基本步驟

在傳統的神經網絡中,每層的輸入可能會受到前一層輸出的影響,使得數據分布發生變化,尤其是在網絡層數較深時,這種變化可能非常劇烈,導致訓練變得困難。批歸一化的主要目的是規范化每一層的輸入,使得它們具有統一的均值和方差。

具體來說,批歸一化的過程可以分為以下幾個步驟:

1.計算每一層輸入的均值和方差

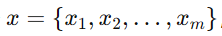

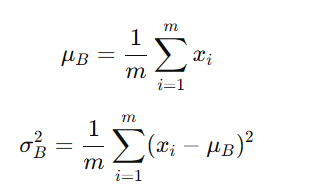

對于輸入數據 計算該批次(batch)數據的均值和方差:

計算該批次(batch)數據的均值和方差:

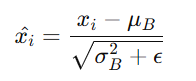

標準化處理:用均值和方差對輸入進行標準化,使得輸出數據的均值為0,方差為1:

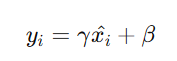

2. 引入可學習參數:為了保留模型的表達能力,批歸一化引入了兩個可學習的參數 γ 和 β 分別用于對標準化結果進行縮放和偏移:

其中,γ 和 β 是在訓練過程中學習到的參數,允許模型恢復到沒有歸一化的形式,或根據需求調整數據的分布。

1.2 訓練與測試階段的區別

在訓練階段,BN是基于當前批次的均值和方差進行標準化處理。然而,在測試階段,由于數據的批量較小(通常是單個樣本),無法使用當前樣本的均值和方差。因此,在測試時,BN使用訓練階段計算出的全局均值和方差進行歸一化,從而確保模型在推理時的穩定性。

二、批歸一化的作用

批歸一化在深度學習中發揮了多重作用,主要包括以下幾個方面:

2.1 加速訓練

批歸一化的一個顯著優點是能夠顯著加速深度神經網絡的訓練過程。這是因為,BN通過將每一層的輸入數據規范化,使得其具有統一的分布,避免了“內部協變量偏移”(Internal Covariate Shift)。在沒有BN的情況下,隨著網絡的訓練,前面一層的權重更新會改變后續層的輸入分布,這會導致后續層需要重新調整權重,訓練過程變得更加緩慢。而有了BN之后,每層的輸入分布保持穩定,從而使得網絡能夠以更大的學習率進行訓練,顯著提高了訓練速度。

2.2 緩解梯度消失和梯度爆炸

梯度消失和梯度爆炸是深度網絡訓練中常見的現象,尤其是在深度網絡或長序列的情況下。批歸一化通過保持每層輸入的均值為0、方差為1,有效減少了輸入數據的偏移,使得梯度在反向傳播時更加平穩。這樣,網絡可以在較大的梯度下進行訓練,減小了梯度消失的風險。

2.3 提高模型的泛化能力

批歸一化還可以有效地提高模型的泛化能力。雖然BN引入了額外的噪聲(每個批次的均值和方差會有所波動),但是這種噪聲可以在一定程度上起到正則化的作用,避免了過擬合。實際上,BN常常能讓模型在較少的正則化方法(如Dropout)的情況下,也能獲得較好的泛化性能。

2.4 允許更高的學習率

由于批歸一化使得每一層的輸入分布穩定,因此可以使用較大的學習率進行訓練。較大的學習率可以加速模型的收斂,同時避免了學習率過低導致的訓練緩慢的問題。

2.5 改善初始化

在沒有批歸一化時,網絡的參數初始化是非常關鍵的,錯誤的初始化可能導致梯度消失或爆炸。然而,批歸一化可以減少對初始化的敏感性,因為它能夠有效地規范化每一層的輸入,從而降低了初始化的影響。

三、批歸一化的局限性和挑戰

盡管批歸一化在深度學習中具有顯著優勢,但它也存在一些局限性和挑戰。

3.1 對小批量數據的依賴

批歸一化需要依賴批次數據的均值和方差進行標準化,因此在處理小批量數據時,統計量可能不穩定,導致性能下降。在極小批量(如batch size=1)或在線學習的情況下,BN的效果會大打折扣。

3.2 計算開銷

批歸一化引入了額外的計算和內存開銷,特別是在每一層都需要計算均值和方差時。在深度網絡和大規模數據集上,計算和存儲這些統計量會增加額外的計算成本,盡管這種開銷通常可以忽略不計。

3.3 在某些任務中的不適用性

盡管批歸一化在許多任務中表現出色,但在某些特定的應用場景下,它可能并不是最佳選擇。例如,在循環神經網絡(RNN)中,由于其處理序列數據的特殊性,BN的應用效果可能不如在卷積神經網絡(CNN)中的表現。為了解決這個問題,一些研究者提出了層歸一化(Layer Normalization)和組歸一化(Group Normalization)等改進方法。

3.4 依賴訓練集的統計量

批歸一化在訓練時依賴當前批次的數據統計量,而這些統計量可能無法完全代表整個訓練集的分布,這可能導致在訓練集變化較大的時候,模型的性能有所下降。

四、批歸一化的變種與擴展

為了克服BN的某些局限性,研究人員提出了許多改進和變種,以下是其中幾種重要的變種:

1. 層歸一化(Layer Normalization):與批歸一化不同,層歸一化是對每一個樣本的所有特征進行歸一化處理,而不是在一個批次內進行歸一化。層歸一化通常用于循環神經網絡(RNN)中,它能夠緩解BN在小批量數據上的表現不佳的問題。

2. 組歸一化(Group Normalization):組歸一化是將特征分成多個小組,在每個小組內進行標準化。與批歸一化不同,組歸一化不依賴于批次大小,因此在小批量學習中也能有效工作。

3. 實例歸一化(Instance Normalization):實例歸一化通常用于圖像生成任務中(如生成對抗網絡),它是對每個圖像的每個通道進行標準化處理,有助于去除樣式的影響。

五、總結

批歸一化(Batch Normalization)是深度學習中一個重要的技術,它通過規范化每一層的輸入數據,使得網絡訓練更加穩定,加速了收斂過程,并且在一定程度上改善了模型的泛化能力。盡管它存在一些局限性,如對小批量數據的依賴以及計算開銷問題,但它仍然是現代深度神經網絡中不可或缺的技術之一。在未來,隨著對神經網絡訓練技術的不斷探索,批歸一化及其變種將在更多應用場景中發揮更大的作用。