不同激活函數對神經網絡性能的影響

時間:2024-12-12 來源:華清遠見

不同激活函數對神經網絡性能的影響

時間:2024-12-12 來源:華清遠見

引言:

在神經網絡的設計中,激活函數扮演著至關重要的角色。它們決定了神經元的輸出如何傳遞到網絡的下一層,進而影響到整個網絡的表現和性能。選擇合適的激活函數不僅能提高模型的準確度,還能加速訓練過程。因此,了解不同激活函數的特點及其對神經網絡性能的影響是深度學習中的一個重要課題。

1. 激活函數的基本概念

激活函數是神經網絡中的非線性函數,它接受一個輸入值,并輸出一個處理過的值。沒有激,活函數,神經網絡就相當于一個線性模型,無法有效地進行復雜的模式學習。而激活函數的非線性特性允許神經網絡學習到復雜的模式。

常見的激活函數包括:Sigmoid、Tanh、ReLU、Leaky ReLU、ELU等,每種激活函數都有其優缺點和適用場景。

2. 常見激活函數及其特點

2.1 Sigmoid 函數

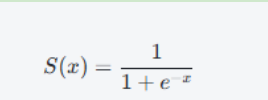

Sigmoid 函數的數學表達式為:

它的輸出范圍是(0,1),使其成為一種概率輸出函數,通常用于二分類問題的輸出層。然而,Sigmoid 函數存在一些缺點:

l 梯度消失問題:當輸入值非常大或非常小時,Sigmoid 的導數接近于0,這會導致梯度消失,進而使得訓練變慢甚至停滯。

l 輸出不是零均值:Sigmoid 輸出的值總是在(0,1)之間,這使得優化過程變得更加困難。

2.2 Tanh 函數

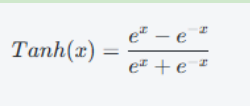

Tanh 函數(雙曲正切函數)是 siqmoid 函數的擴展,它的輸出范圍是(-1,1),并且具有更好的梯度性質。其數學表達式為:

Tanh 函數的優點包括:

l 零均值輸出:Tanh 的輸出范圍是(-1,1),這使得網絡的訓練更加穩定。

l 較少的梯度消失問題:相較于 Sigmoid,Tanh 在較大范圍的輸入時仍能提供較強的梯度,降低了梯度消失的影響。

然而,Tanh 函數也存在類似的問題:它的輸出仍然是飽和的,導致在極端值時會發生梯度消失。

2.3 ReLU 函數

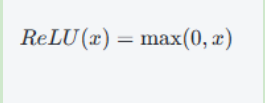

ReLU(Rectified Linear Unit,修正線性單元)是目前深度學習中最常用的激活函數之-

其數學表達式為:

ReLu 的優點包括:

l 計算簡單:RelU 函數非常簡單,計算效率高。

l 避免梯度消失:ReLU 在正半軸上具有常數梯度,避免了梯度消失問題,尤其適用于深度神經網絡。

l 稀疏性:由于 ReLU 在負半軸輸出為0,它具有稀疏性,使得神經網絡更加高效。

然而,ReLU 也有一個問題死神經元問題。當輸入小于零時,ReLU 輸出為0,可能導致一些神經元的輸出始終為零,這些神經元不再更新,無法參與訓練。

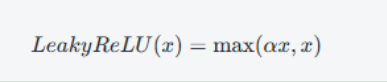

2.4 Leaky ReLU 和 Parametric ReLU

為了緩解 ReLU 的死神經元問題,Leaky ReLU 被提出。其數學形式為:

其中,a是一個非常小的常數,通常取值如 0.01。Leaky Relu 在負軸上不會完全變為 0,而是給出一個小的負值,從而避免了神經元"死亡"問題Parametric RelU(PReLU)是 Leaky Rel 的一個擴展,其中 α 是可學習的參數。通過訓練,PReLU 可以自適應地選擇最合適的負斜率。

2.5 ELU 函數

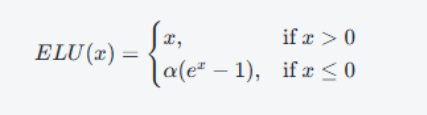

ELU(Exponential Linear Unit)是另一種被提出的激活函數,公式為:

ELU 的優點是:

l 避免梯度消失問題:與 ReLU 類似,ELU 在正半軸有恒定的梯度,而在負半軸的輸出通過指數函數進行平滑過渡。

l 改善訓練速度:相比于 ReLU,ELU 在負半軸具有負值,可以使得網絡在訓練過程中有更好的收斂性。

ELU 的缺點是計算復雜度較高,且當。 的選擇不當時,可能會導致訓練不穩定。

1. 激活函數的選擇對性能的影響

不同的激活函數對于神經網絡的性能有不同的影響,具體體現在以下幾個方面:

l 收斂速度:RelU 和其變種(如 Leaky ReLU、PReU、ELU)由于避免了梯度消失問題,通常具有更快的收斂速度。而像、sigmoid 和Tanh 可能由于梯度消失或梯度飽和,導致訓練變慢。

l 準確度:在很多任務中,ReLU 和ELU 的表現往往優于 sigmoid和 Tnh,尤其是在處理較深的網絡時。Rel 通常能夠提供更高的準確度和更好的泛化能力。

l 梯度消失向題:sigmoid 和 anh函數容易在較大的輸入值下出現梯度消失問題,這使得它們在深度網絡中表現較差。ReU 和 ELU 等函數能夠緩解這一問題,特別是在深度網絡的訓練中表現更為穩定。

l 非線性與稀疏性:ReL 的稀疏性使得其網絡在處理某些任務時具有優勢,尤其是在大規模數據集上,能夠有效減輕計算負擔。

2. 結論

選擇合適的激活函數對于神經網絡的性能至關重要。對于大多數現代深度學習模型,RelU 和其變種(LeakyRU、ELU、PReLU)通常是最常用的選擇,因為它們能有效避免梯度消失問題,并且訓練速度較快。然而,針對特定任務和數據,可能需要進行一定的實驗和調整,選擇最適合的激活函數。隨著研究的深入,未來可能會出現更多新的激活函數,以更好地解決現有方法的缺點和局限性。

在構建和訓練神經網絡時,理解激活函數的特性、優缺點,以及它們如何影響模型的性能,是每個深度學習從業者不可忽視的重要環節。